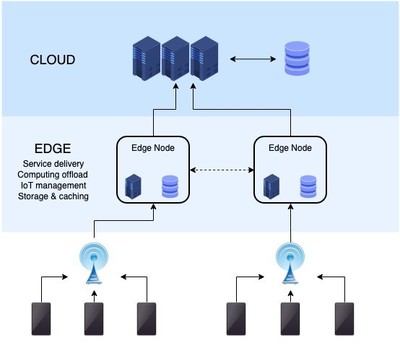

在物聯網邊緣計算架構中,Kafka作為高吞吐量的分布式消息系統,發揮了關鍵的數據處理和存儲作用。其核心優勢包括高吞吐、低延遲和分布式架構,特別適合應對物聯網設備產生的海量數據流。

Kafka在邊緣計算中的數據處理流程

- 數據采集與緩沖:邊緣設備通過Kafka生產者API將實時數據(如傳感器讀數、設備狀態)發布到Kafka主題。Kafka的持久化日志結構可作為數據緩沖區,有效緩解網絡波動導致的數據丟失風險。

- 流式處理集成:結合Kafka Streams或KSQL,可在邊緣節點直接實現數據過濾、聚合和轉換。例如對溫度傳感器數據實時計算移動平均值,僅將異常結果上傳至云端。

- 多級數據分發:通過Kafka Connect將數據同步到邊緣數據庫(如SQLite)或云存儲(如S3),同時支持將關鍵數據轉發至云端Kafka集群進行深度分析。

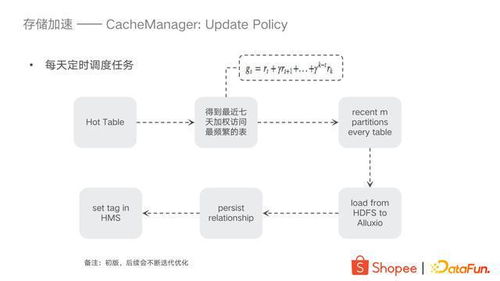

存儲策略優化

- 分層存儲配置:設置合理的日志保留策略,對實時數據保留24小時,重要數據通過壓縮主題長期存儲

- 數據序列化:采用Avro格式序列化數據,結合Schema Registry確保邊緣與云端數據格式一致性

- 容災機制:在邊緣網關部署Kafka鏡像節點,通過副本機制保障單點故障時的數據可用性

實踐案例參考

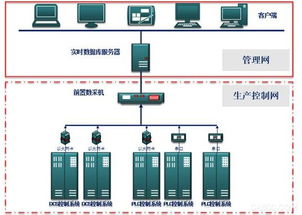

某智能制造企業在產線邊緣部署Kafka集群,每臺機床通過MQTT-Kafka橋接器上報運行參數。邊緣計算節點實時分析設備故障特征,當檢測到異常振動模式時,立即通過Kafka消息觸發本地告警,同時將精簡后的診斷數據批量上傳至云平臺。這種架構使核心業務邏輯在邊緣完成,帶寬占用降低70%,故障響應時間從秒級優化至毫秒級。

注意事項

- 需根據邊緣設備資源限制調整Kafka內存配置

- 建議使用輕量級Docker容器部署邊緣Kafka節點

- 通過TLS加密和SASL認證保障邊緣數據傳輸安全

通過合理運用Kafka的流處理能力和存儲特性,物聯網邊緣計算可構建出兼具實時性、可靠性和可擴展性的數據處理體系。