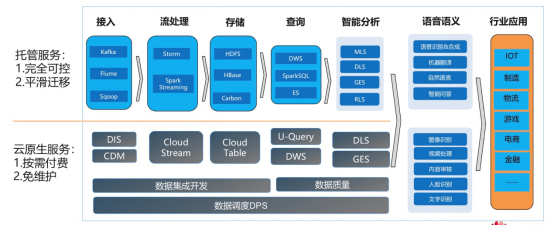

大數據處理系統是由大量服務器、高速網絡和大規模存儲設備構成的復雜基礎設施,其數據處理和存儲服務的開展遵循系統化的工作流程。

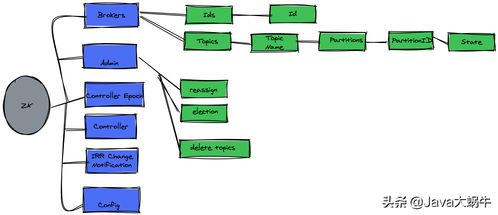

在數據處理方面,系統首先通過分布式采集技術從多樣化數據源(如傳感器、日志文件、數據庫等)獲取原始數據。數據進入系統后會經過清洗、轉換和集成等預處理環節,以消除噪聲并統一格式。核心處理階段采用分布式計算框架(例如Hadoop MapReduce或Spark),將任務分解為多個子任務并行執行于集群節點上,顯著提升處理效率。流處理引擎(如Flink或Storm)則支持實時數據分析,滿足對即時洞察的需求。處理結果通過數據可視化工具或API接口交付給用戶。

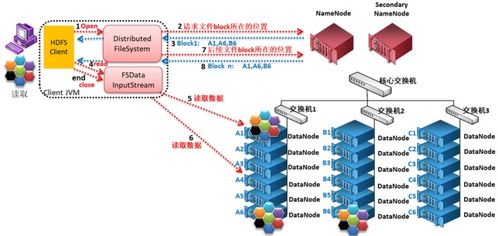

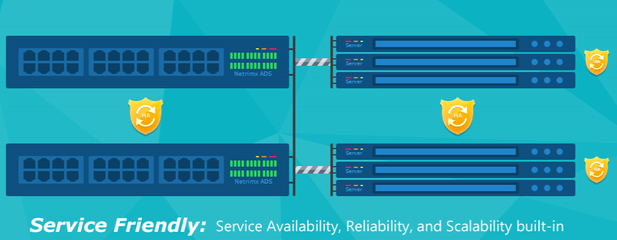

在存儲服務方面,系統依賴分布式文件系統(如HDFS)或對象存儲(如Amazon S3)來管理海量數據。這些存儲方案通過數據分片和副本機制確保高可用性和容錯性;數據通常根據訪問頻率被分層存儲,冷數據移至成本較低的歸檔存儲,而熱數據保留在高速介質中。元數據管理系統跟蹤數據位置與屬性,便于快速檢索。安全措施如加密和訪問控制貫穿整個流程,保障數據隱私。

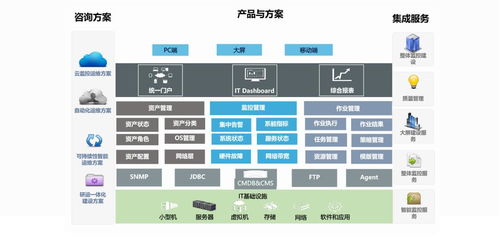

整體上,大數據系統的服務開展依賴于軟硬件協同,通過自動化調度與監控工具優化資源利用,從而高效、可靠地支持企業決策與創新應用。